Langage naturel et intelligence artificielle

Titulaire de la chaire Linguistique générale, le Pr Luigi Rizzi explore les liens entre langage naturel et intelligence artificielle à l’occasion du colloque The Representation of Language in Brains and Machines qu’il organise au Collège de France les 24 et 25 juin avec les Prs Stanislas Dehaene et Stéphane Mallat.

Qu’est-ce que la linguistique ?

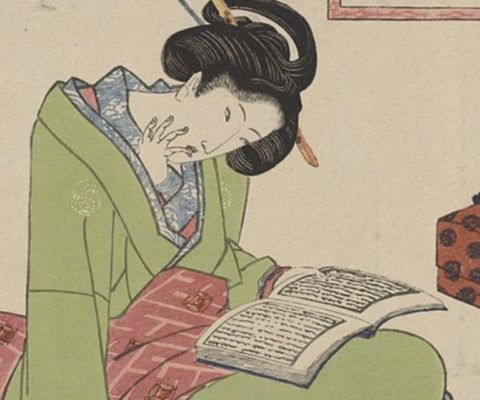

Le langage est l’une des caractéristiques saillantes de notre espèce. Il nous permet d’articuler des pensées complexes et il a un rôle fondamental dans presque toutes les formes de l’activité humaine : entre autres, il nous permet de communiquer avec les autres, de tisser des liens sociaux, d’apprendre et faire apprendre. Nous vivons immergés dans le langage. Il est donc naturel qu’un aspect aussi important de notre vie soit soumis à l’étude scientifique.

Il y a une vaste recherche fondamentale sur le langage : nous voulons comprendre quels sont ses ingrédients de base, ses modes de fonctionnement, les facteurs qui font varier les langues dans l’espace et dans le temps. C’est le champ d’étude de la linguistique générale.

Cette quête est motivée par la curiosité, comme toute recherche fondamentale dans les sciences naturelles et humaines. Mais la constitution d’un corps de connaissances sur le langage nourrit aussi une recherche appliquée dont l’impact social est vaste et différencié : sur l’enseignement des langues étrangères, par exemple ; ou sur le diagnostic lié aux pathologies du langage et les stratégies thérapeutiques à adopter ; ou encore, bien-sûr, sur les applications informatiques.

Quels liens existe-t-il entre linguistique et intelligence artificielle ? Pourquoi l’usage de la linguistique est primordial en matière d’intelligence artificielle ?

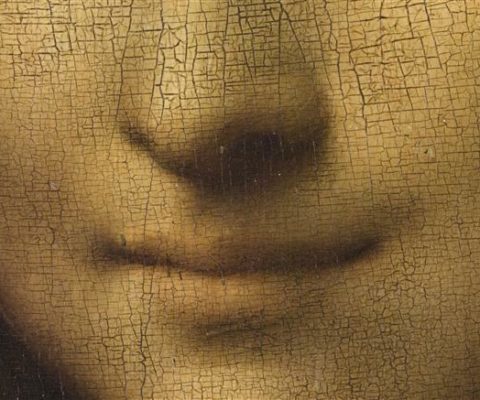

On pense à l’intelligence artificielle comme à un domaine d’études très récent, mais les questions que vous posez ont des racines anciennes. René Descartes pensait à l’usage du langage comme à un test nous permettant de départager l’homme d’une machine, aussi perfectionnée soit-elle : si je parle à quelqu’un et s’il me répond essentiellement comme je le ferais à sa place, c’est-à-dire de manière certes appropriée au contexte, mais non pas déterminée par lui (ce qu’on a appelé la « créativité dans l’usage normal du langage »), je peux être sûr qu’il s’agit d’un humain, pas d’un automate. Et, au début des années 50 du siècle dernier, Alan Turing se posait la question : est-ce que les machines peuvent « penser » ? ou plutôt : comment pouvons-nous formuler cette question de manière intéressante et utile ? Dans les derniers 70 ans, l’informatique a fait des pas gigantesques (et d’ailleurs c’est bien Turing qui en a défini les bases formelles) ; et nos ordinateurs sont infiniment plus puissants et polyvalents que les automates qui fascinaient les savants au XVIIème siècle. Néanmoins, les questions posées par Descartes et Turing gardent toute leur actualité. Est-ce que l’ordinateur peut reproduire les capacités linguistiques humaines ? Voilà une question d’un grand intérêt théorique, mais aussi riche d’implications pour les applications informatiques.

Pourquoi lire, écrire, parler et traduire est-il si compliqué pour une intelligence artificielle ?

Dans les années 50 la traduction automatique d’une langue à l’autre était l’un des buts que l’informatique, à sa naissance, s’était donnés. L’une des premières contributions du linguiste Noam Chomsky a été de montrer que les modèles informatiques développés à l’époque étaient beaucoup trop pauvres pour pouvoir aborder avec succès la complexité des langues naturelles. Dans les derniers 60 ans, les progrès de l’informatique ont été énormes, ce qui est visible dans les applications dont notre vie quotidienne dépend si profondément aujourd’hui. Néanmoins, le langage reste encore un défi important : les ordinateurs sont capables de battre les grands maîtres d’échecs mais certaines propriétés structurales qui sont accessibles à l’enfant au début de la scolarisation restent difficiles pour les applications informatiques. Ce qui montre deux choses : le langage naturel est très complexe et notre espèce est très bien adaptée pour l’utiliser.

Comment travaillent les linguistes pour y remédier ?

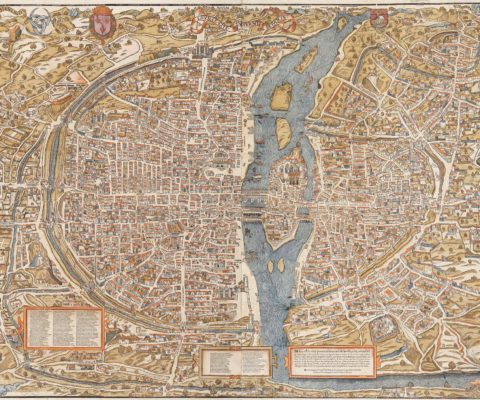

Dans les années 70 et 80, les rapports entre la linguistique formelle et l’informatique étaient très forts, au point qu’on avait créé une nouvelle discipline, la linguistique informatique. Suite à la persistance de certaines difficultés, les rapports se sont affaiblis dans les années suivantes, les linguistes ont moins investi dans l’étude des modèles computationnels, et les informaticiens ont beaucoup développé des modèles qui ne tenaient pas compte du savoir entre temps accumulé par les linguistes sur la structure du langage. De tels modèles, fondés sur la statistique et, récemment, sur les techniques dites de « deep learning » ont eu un succès remarquable qui a permis la mise au point de nombreuses applications performantes dans l’interaction homme-machine, y compris dans le domaine de la traduction. Néanmoins, certains problèmes persistent. D’abord des problèmes liés à l’organisation hiérarchique du langage. Si nous considérons n’importe quelle phrase, elle se présente à nos sens comme une séquence d’éléments : par exemple, à l’écrit, je vois une séquence de lettres qui forment des mots, eux-mêmes organisés en séquence. Mais l’organisation linéaire cache une organisation hiérarchique, invisible mais beaucoup plus importante pour le fonctionnement du langage. Par exemple, dans une petite phrase comme Les amis de mes parents partent nous comprenons que ce sont les amis qui partent, pas mes parents, malgré le fait que l’expression nominale « mes parents » soit la plus proche du verbe. Notre cerveau prête attention à la configuration hiérarchique, non pas à la proximité linéaire entre les mots. Un système artificiel capable de reproduire les capacités humaines doit donc pouvoir bâtir des représentations hiérarchiques pour les phrases. L’apport que les linguistes peuvent donner c’est de porter à l’attention des informaticiens ces propriétés constitutives du langage, comme l’organisation hiérarchique (et bien d’autres : le mouvement, les propriétés de l’interface syntaxe-sémantique, etc.) qui ne sont pas immédiatement visibles dans les textes et dans les énoncés, mais qui jouent un rôle crucial dans la forme et l’interprétation des expressions linguistiques.

Qu’a apporté l’intelligence artificielle à la linguistique ?

Ici il est opportun de distinguer deux visions des buts de l’intelligence artificielle, les deux parfaitement légitimes mais bien distinctes.

On peut voir la construction de systèmes « intelligents » artificiels comme un pur travail d’ingénieur, la construction d’un système qui marche pour un but pratique, un système qui maîtrise la morphologie complexe d’une langue, ou un système de traduction, par exemple. On peut alors procéder sans tenir compte de comment les systèmes naturels marchent, par exemple comment l’enfant apprend la morphologie complexe, ou comment le traducteur humain opérerait. Ici le but est pratique, et le succès du projet se mesure sur la base de l’efficacité, non pas sur la fidélité de la simulation de la capacité humaine.

Cependant, il est possible aussi d’utiliser l’intelligence artificielle dans le but explicite de modéliser les capacités linguistiques humaines, afin d’accroître nos connaissances sur un objet naturel. Une telle approche devra, par exemple, tenir compte de la quantité et de la qualité des données auxquelles l’enfant a accès dans l’apprentissage : un système artificiel exigeant un corpus d’entrainement disproportionné par rapport à l’ensemble des données accessibles à l’enfant ne sera pas un bon modèle de l’apprentissage du langage. Une telle approche devra aussi tenir compte des résultats des neurosciences sur le fonctionnement de la machine neuronale naturelle mise en jeu dans le langage, pour déterminer quelles architectures artificielles sont biologiquement plausibles. Dans cette conception, l’intelligence artificielle peut être un instrument précieux pour mieux comprendre les mécanismes mentaux humains étudiés dans le cadre des neurosciences cognitives.

Ces questions et problèmes seront abordés au prochain colloque The Representation of Language in Brains and Machines, organisé au Collège de France les 24-25 juin par Stanislas Dehaene, Stéphane Mallat et moi-même.

Propos recueillis par Flavie Dubois-Mazeyrie

![[VIDÉO] Comment s’arrêtent les pandémies ?](https://www.fondation-cdf.fr/wp-content/uploads/2022/04/masque-rue-480x400.jpeg)

![[VIDÉO] Agir pour l’éducation](https://www.fondation-cdf.fr/wp-content/uploads/2021/12/Capture-décran-2021-12-02-à-18.28.29-480x400.png)

![[VIDÉO] Un monument de la pensée : le cours de Poétique de Valéry](https://www.fondation-cdf.fr/wp-content/uploads/2021/10/4K1B8515-480x400.jpg)

![[VIDÉO] Réflexions sur la vérité scientifique dans une époque trouble](https://www.fondation-cdf.fr/wp-content/uploads/2019/10/S.Haroche-conf-480x400.jpg)